IA e corporate governance: un valido ausilio ma anche tanti nuovi rischi

La diffusione di questa nuova tecnologia promette di avere un forte impatto anche sul mondo delle imprese e sulla relativa corporate governance. I board non potranno fare altro che includere adeguatamente le questioni relative all'intelligenza artificiale nella propria agenda. Ai consiglieri indipendenti l’obbligo di un approccio di supervisione

Getty Images

Getty Images

L’intelligenza artificiale (IA o AI in inglese), in quanto tecnologia trasformativa, ha la capacità di rivoluzionare interi settori, creando nuove opportunità di sviluppo e presentando nuovi rischi per le istituzioni, le imprese, le autorità di regolamentazione e di vigilanza, i cittadini. In un recente vertice dei CEO a Yale, il 42% ha indicato di essere preoccupato per l’impatto potenzialmente catastrofico dell’intelligenza artificiale.[1] Goldman Sachs prevede tassi di sviluppo a doppia cifra e investimenti globali oltre i 200 miliardi di dollari entro il 2025.

L’IA ha la capacità di innovare e rivoluzionare interi settori, con implicazioni su: (i) sostenibilità della strategia e del modello di business aziendale, (ii) identificazione e gestione dei rischi per l’impresa connessi alle questioni di sostenibilità in considerazione dei fattori ambientali, sociali e di governance (ESG), (iii) conformità con la normativa di riferimento e sulle relazioni con gli stakeholder. Tutti ambiti che richiedono l’attenzione sistematica dell’organo con funzione di gestione e dell’organo di supervisione strategica.

L’OECD, nel 2019, ha adottato le Recommendation of the Council on Artificial Intelligence[2] in cui è stata inserita una definizione di “AI system”: «Sistema di intelligenza artificiale: un sistema di intelligenza artificiale è un sistema basato su macchina che, per obiettivi espliciti o impliciti, deduce, dall’input che riceve, come generare output come previsioni, contenuti, raccomandazioni o decisioni che possono influenzare ambienti fisici o virtuali. Diversi sistemi di intelligenza artificiale variano nei loro livelli di autonomia e adattività dopo l’implementazione».

Quadro internazionale

Nell’ultimo decennio la «finanza digitale» – consistente in tecnologie innovative come l’intelligenza artificiale (IA), il machine learning (ML), le tecnologie di registro distribuito (distributed ledger technologies – blockchain), i big data e il cloud computing – ha trasformato in modo significativo il sistema finanziario, dando origine a nuovi prodotti, servizi, applicazioni, processi e modelli di business.[3] L’intelligenza artificiale sta impattando in maniera crescente, ad esempio, anche nelle città.[4] Governi e parlamenti vigilano sull’evoluzione del fenomeno. A livello nazionale, il Dipartimento per la trasformazione digitale della Presidenza del Consiglio è fortemente attivo anche sulla tematica dell’IA. Il Senato della Repubblica e la Camera dei Deputati hanno reso disponibile un ampio Dossier.[5]

Negli Stati Uniti sono all’esame una serie di attività legislative e regolamentari, sia a livello federale che statale, coinvolgenti anche le Agenzie federali. In questo quadro è stata promossa un’attività regolamentazione attraverso il National Institute of Standards and Technology facente capo all’U.S. Department of Commerce, consistente nella pubblicazione dell’Artificial Intelligence Risk Management Framework (AI RMF).[6] L’executive summary dell’AI RMF specifica che «le tecnologie di intelligenza artificiale (IA) hanno un potenziale significativo per trasformare la società e la vita delle persone: dal commercio e la salute ai trasporti e alla sicurezza informatica, fino all’ambiente e al nostro pianeta. Le tecnologie dell’intelligenza artificiale possono favorire una crescita economica inclusiva e sostenere i progressi scientifici che migliorano le condizioni del nostro mondo. Le tecnologie di intelligenza artificiale, tuttavia, presentano anche rischi che possono avere un impatto negativo su individui, gruppi, organizzazioni, comunità, società, ambiente e pianeta. Come i rischi per altri tipi di tecnologia, l’intelligenza artificiale i rischi possono emergere in vari modi e possono essere caratterizzati come a lungo o breve termine, ad alta o bassa probabilità, sistemici o localizzati e ad alto o basso impatto».[7]

Nell’AI RMF è sottolineata, in maniera particolare la responsabilità sociale. La responsabilità sociale può riferirsi alla «responsabilità dell’organizzazione “per gli impatti delle sue decisioni e attività sulla società e sull’ambiente attraverso un comportamento trasparente ed etico” (ISO 26000:2010). La sostenibilità si riferisce allo “stato del sistema globale, compresi gli aspetti ambientali, sociali ed economici, in cui i bisogni del presente sono soddisfatti senza compromettere la capacità delle generazioni future di soddisfare i propri bisogni” (ISO/IEC TR 24368:2022). L’intelligenza artificiale responsabile deve portare a una tecnologia che sia anche equa e responsabile. L’aspettativa è che le pratiche organizzative siano condotte in accordo con la “responsabilità professionale”, definita dall’ISO come un approccio che “mira a garantire che i professionisti che progettano, sviluppano o implementano sistemi e applicazioni di intelligenza artificiale o prodotti o sistemi basati sull’intelligenza artificiale, riconoscano la loro posizione unica per esercitare un’influenza sulle persone, sulla società e sul futuro dell’intelligenza artificiale».

Regolamento europeo e Risk-based approach

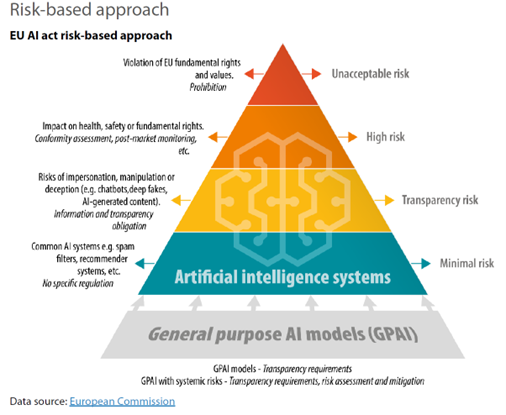

L’Unione europea (UE), collocandosi tra le regioni maggiormente innovative a livello globale, ha adottato una legislazione innovativa mediante uno specifico Regolamento[8] sull’intelligenza artificiale (“Artificial Intelligence Act”), che stabilisce obblighi e limiti all’utilizzo dell’IA sulla base dei possibili rischi e del livello d’impatto.[9]

Il Regolamento europeo ha definito un General Purpose AI Model” (GPAI), ossia un modello di intelligenza artificiale generativa che, in quanto fondamentale per lo sviluppo dei vari sistemi AI, sarà soggetto a obblighi di trasparenza e valutazione del rischio, con una distinzione tra modelli generici e sistemici. Strumenti e ambiti che verranno orientati attraverso il cosiddetto “risk-based approach” finalizzato alla individuazione di sistemi di AI con rischio inaccettabile (che saranno vietati), rischio alto, rischio limitato (transparency risk) e rischio minimo.

(Figura 1 | Rischi connessi al modello di intelligenza artificiale generativa, GPAI)

Implicazioni sulla corporate governance

Secondo Rogers[10] il processo che rende la società permeabile ad una innovazione tecnologica si fonda su due momenti chiave: l’adozione e la diffusione. L’adozione riguarda le strategie decisionali che portano l’individuo a fare propria una particolare tecnologia, mentre la diffusione costituisce un momento essenzialmente sociale caratterizzato da cinque fasi.[11]

Postulato che la fase in corso attenga la «diffusione» delle tecnologie di intelligenza artificiale, gli amministratori dovrebbero comprendere l’impatto dell’intelligenza artificiale sull’impresa e gli obblighi che ne derivano, le opportunità ed i rischi, applicando lo stesso approccio di supervisione generale applicato ad altre tematiche di gestione, comprendenti adempimenti e conformità, monitoraggio sistematico dei rischi mediante specifiche analisi e informative. A tal fine i consigli di amministrazione, con i manager aziendali, dovrebbero considerare quantomeno le seguenti variabili:

- in che modo l’intelligenza artificiale potrebbe impattare sui mercati ovvero incidere nel settore operativo dell’impresa creare opportunità strategiche non ancora colte, promuovere un vantaggio competitivo o minacciare di sconvolgere il business;

- come l’intelligenza artificiale viene attualmente utilizzata dall’impresa e dalle imprese concorrenti;

- le implicazioni strategiche originate dall’intelligenza artificiale ai fini della continuità aziendale e del successo sostenibile dell’impresa;

- la sostenibilità e dei rischi associati alla evoluzione dei mercati con particolare riferimento ai prodotti ed ai servizi dell’impresa e valutazione dell’appropriatezza del business model;

- come l’intelligenza artificiale potrebbe supportare l’innovazione, la ricerca e lo sviluppo, contribuire a migliorare l’esperienza dei clienti, gestire la catena di fornitura, gestire i rischi, migliorare l’efficienza dell’impresa e ridurne i costi;

- il possibile impatto delle applicazioni di intelligenza artificiale sulla forza lavoro, sulla salvaguardia dei dati, sulla filiera industriale e in generale su tutti gli stakeholder;

- le implicazioni e gli adempimenti funzionali al pieno rispetto degli obblighi normativi, regolamentari ed etici;

- la necessità di adozione di appropriate policy e di un adeguato sistema dei controlli interni al fine di verificare che i sistemi di intelligenza artificiale siano sicuri e che l’assunzione dei rischi sia consapevole e prudente, in un’ottica di lungo periodo;

- i rischi operativi, finanziari, di conformità e di reputazione interdipendenti dall’intelligenza artificiale;

- le implicazioni per la corporate governance in relazione all’uso dell’intelligenza artificiale, nella consapevolezza che la cultura del rischio, soprattutto per gli enti bancari e finanziari, è stata riconosciuta come un elemento importante della governance nel quadro regolamentare a livello internazionale, europeo e nazionale.[12]

Il consiglio di amministrazione (o il comitato endoconsilare responsabile) dovrebbe pertanto includere adeguatamente le questioni relative all’intelligenza artificiale nella sua agenda[13] e considerare: a) se è regolarmente aggiornato sugli sviluppi legislativi e normativi rapidamente emergenti relativi all’uso dell’intelligenza artificiale; b) se siano state esaminate le politiche e le procedure aziendali relative all’uso dell’IA; c) se siano state considerate, insieme al management, le implicazioni dell’intelligenza artificiale per la sicurezza informatica, la privacy e altre politiche di conformità e programmi di controllo dell’azienda; d) se siano state analizzate con il management il potenziale di uso improprio e le conseguenze indesiderate derivanti dall’uso dell’IA da parte dell’azienda rispetto a dipendenti, clienti, altri stakeholder chiave e all’ambiente, e come evitare o mitigare tali rischi; e) se sia stato compresa la misura in cui l’intelligenza artificiale viene utilizzata per monitorare e valutare le prestazioni dei dipendenti e se siano garantiti controlli sistematici per recepire ed assicurare la conformità con qualsiasi normativa pertinente; f) se sia stato individuato il soggetto che all’interno dell’azienda è responsabile del monitoraggio dell’uso dell’IA, della conformità specifica dell’IA e della gestione dei rischi, e in che modo l’azienda garantisce la conformità ai requisiti specifici dell’IA, come i requisiti “security-by-design”; g) se siano supervisionate le politiche e le procedure dell’azienda relative all’uso dell’intelligenza artificiale generativa, compreso se tali politiche e procedure considerano il potenziale di parzialità, inesattezza, violazione della privacy e questioni correlate di protezione dei consumatori, sicurezza informatica e dei dati, protezione della proprietà intellettuale e controllo di qualità.

I dati dell’indagine condotta negli Stati Uniti dalla NACD[14] rivelano che il 95% degli amministratori ritiene che l’intelligenza artificiale avrà in qualche modo un impatto sulla propria attività nel prossimo anno. Tuttavia, solo Il 28% degli intervistati indica che l’intelligenza artificiale costituisce un argomento regolare nelle conversazioni del consiglio di amministrazione. I consigli di amministrazione prevedono un impatto significativo da parte dell’intelligenza artificiale sulle loro attività e pertanto dovranno valutare la propria preparazione e attrezzarsi per questa nuova area di supervisione nelle cinque aree indicate di seguito.[15]

(Figura 2 | AI Governance | Le cinque aree da presidiare)

(Fonte: NACD)

Conclusioni

Le considerazioni che precedono dovrebbero essere analizzate tempestivamente sia ai fini della sostenibilità del business nel lungo termine, che implica l’identificazione, la valutazione e la gestione dei rischi connessi ai fattori Ambientali, sociali e di governance (ESG), in quanto costituiscono il presupposto fondamentale per la continuità aziendale; sia alla luce di una serie di norme cogenti, tra cui (i) la nuova normativa bancaria basata sui Principi di Basilea 3.1, armonizzato attraverso un corpus unico di norme, con particolare riferimento agli obiettivi di rafforzamento della gestione del rischio e della governance a livello di impresa (Pilastro 2); (ii) la Direttiva (UE) 2022/2464 inerente la rendicontazione societaria di sostenibilità (CSRD);[16] nonché in considerazione dei Principi di governo societario del G20/OCSE che rappresentano lo standard internazionale per il governo societario. Tanto nella consapevolezza che il conseguimento del «successo sostenibile», come definito dal Codice di Corporate Governance, implica l’adozione di un approccio olistico alla risk governance.

[1] V. Chief Executive, At Yale CEO Event Honoring Steven Spielberg, Little Consensus on AI Future.

[2] V. OECD, Recommendation of the Council on Artificial Intelligence, OECD/LEGAL/0449 (adottate il 22/05/2019 08/11/2023) (file:///C:/Users/giamp/Downloads/OECD-LEGAL-0449-en.pdf)

[3] V. Digital Finance in the EU: drivers, risks, opportunities, European University Institute, 2023

[4] V. Guiding principles for artificial intelligence in cities (U4SSC). (https://u4ssc.itu.int/publications)

[5] V. Dossier (XIX Legislatura) 25 gennaio 2024 – Senato della Repubblica e Camera dei Deputati. (https://documenti.camera.it/leg19/dossier/pdf/RI039.pdf?_1712266388009)

[6] V. Artificial Intelligence Risk Management Framework (AI RMF 1.0), January 2023. (https://nvlpubs.nist.gov/nistpubs/ai/NIST.AI.100-1.pdf )

[7] Nell’AI RMF è specificato che un sistema di intelligenza artificiale costituisce «un sistema ingegnerizzato o basato su macchina che può, per un dato insieme di obiettivi, generare output come previsioni, raccomandazioni o decisioni che influenzano ambienti reali o virtuali. I sistemi di intelligenza artificiale sono progettati per funzionare con diversi livelli di autonomia».

[8] V. Regolamento (UE) del Parlamento Europeo e del Consiglio (approvato dal Parlamento europeo il 13 marzo 2024) che stabilisce regole armonizzate sull’intelligenza artificiale e modifica i regolamenti (CE) n. 300/2008, (UE) n. 167/2013, (UE) n. 168/2013, (UE) 2018/858, (UE) 2018/1139 e (UE) 2019/2144 e le direttive 2014/90/UE, (UE) 2016/797 e (UE) 2020/1828 (legge sull’intelligenza artificiale). (https://www.europarl.europa.eu/doceo/document/A-9-2023-0188-AM-808-808_IT.pdf )

[9] Come rilevabile sito del Parlamento europeo, ad esempio le disposizioni contenute nel Regolamento «mettono fuori legge alcune applicazioni di IA che minacciano i diritti dei cittadini. Tra queste, i sistemi di categorizzazione biometrica basati su caratteristiche sensibili e l’estrapolazione indiscriminata di immagini facciali da internet o dalle registrazioni dei sistemi di telecamere a circuito chiuso per creare banche dati di riconoscimento facciale. Saranno vietati anche i sistemi di riconoscimento delle emozioni sul luogo di lavoro e nelle scuole, i sistemi di credito sociale, …».

[10] V. Rogers, Everett (2003), Diffusion of Innovations, 5th Edition. Free Press, NY

[11] Queste dinamiche si basano su un processo a cinque fasi così organizzato: la fase di consapevolezza (awareness) in cui l’individuo prende atto dell’innovazione; la fase di interesse (interest); la fase di valutazione (evaluation); la fase della prova (trial); la fase dell’adozione (adoption), nella quale l’individuo diviene pienamente consapevole dei benefici e delle criticità apportate dalla tecnologia e in base a ciò decide se continuarne l’utilizzo.

[12] V. Circolare 285 della Banca d’Italia e documenti del Financial Stability Board, del Comitato di Basilea e dell’Autorità Bancaria Europea.

[13] V. Holly J. Gregory, Sidley Austin LLP (2023), AI and the Role of the Board of Directors. Harvard Law School Forum on Corporate Governance.

[14] V. NACD, 2023 Public Company Board Practices and Oversight Survey (Arlington, Virginia: NACD, 2023), p. 3.

[15] AI and Board Governance (V. file:///C:/Users/giamp/Downloads/de_ai_nacd_and_data_trust_alliance_0923-1.pdf)

[16] V. Direttiva (UE) 2022/2464 che modifica il regolamento (UE) n. 537/2014, la direttiva 2004/109/CE, la direttiva 2006/43/CE e la direttiva 2013/34/UE per quanto riguarda la rendicontazione societaria di sostenibilità (CSRD)